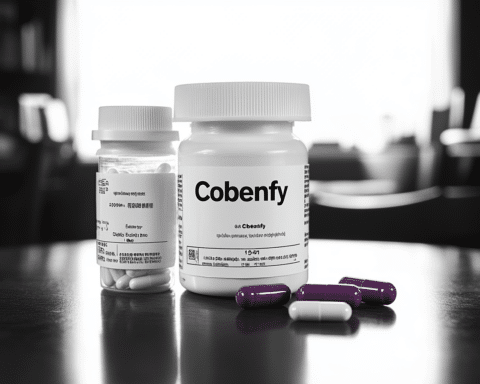

Tessa, ein Chatbot mit künstlicher Intelligenz, der entwickelt wurde, um Menschen mit Essstörungen zu helfen, wurde suspendiert, nachdem Vorwürfe aufgetaucht waren, dass er schlechte Ratschläge zum Abnehmen verbreitet.

Die U.S. National Eating Disorder Association (NEDA) hat Tessa eingeführt und damit alle menschlichen Positionen in ihrer Beratungsstelle abgeschafft.

Sharon Maxwell, eine Aktivistin, teilte auf Instagram ihre Erfahrungen mit Tessa. Sie behauptete, dass der Chatbot Strategien zur Gewichtsabnahme vorschlug, wie z.B. die Einhaltung eines täglichen Defizits von 500 bis 1.000 Kalorien, wöchentliche Gewichtskontrollen und Kalorienzählen.

„Tessas Empfehlungen spiegeln genau die Dinge wider, die meine Essstörung ausgelöst haben. Dieser KI-Bot ist schädlich“, kommentierte Maxwell.

Alexis Conason, eine auf die Behandlung von Essstörungen spezialisierte Psychologin, konnte während ihrer Interaktion mit dem Chatbot ähnliche schädliche Ratschläge wiedergeben.

Screenshots der Chatbot-Antworten zeigten: „Im Allgemeinen ist ein Gewichtsverlust von 1 bis 2 Pfund pro Woche eine sichere und nachhaltige Gewichtsabnahme. Ein tägliches Kaloriendefizit von etwa 500-1000 Kalorien wäre angemessen, um dies zu erreichen.“

Als Reaktion auf diese Anschuldigungen gab die NEDA eine Erklärung ab, in der sie mitteilte, dass sie die Angelegenheit „unverzüglich“ untersucht und das Programm bis auf weiteres deaktiviert hat.

Die Geschäftsführerin von NEDA, Liz Thompson, führte das angebliche Versagen von Tessa auf „böswillige Akteure“ zurück, die versuchten, das Tool auszunutzen. Sie fügte hinzu, dass die schädlichen Ratschläge nur an einen Bruchteil der 2.500 Personen gegeben wurden, die seit dem Start des Bots im Februar des vergangenen Jahres mit ihm interagiert haben.

In der Zwischenzeit haben die entlassenen Mitarbeiter der NEDA-Helpline Klage wegen unlauterer Arbeitspraktiken gegen die Non-Profit-Organisation eingereicht. Sie behaupten, dass sie in einem Versuch, die Gewerkschaft zu zerschlagen, ungerechtfertigt entlassen wurden, nachdem sie sich im März entschieden hatten, sich gewerkschaftlich zu organisieren.

Abbie Harper, Mitarbeiterin der Helpline und Gewerkschaftsmitglied, erklärte in einem Blogbeitrag: „Wir forderten eine ausreichende Personalausstattung, kontinuierliche Schulungen, um mit unserer sich entwickelnden Helpline Schritt zu halten, und Aufstiegsmöglichkeiten innerhalb der NEDA. Wir haben nicht einmal eine Gehaltserhöhung gefordert. Als NEDA unsere Forderungen ablehnte, beantragten wir beim National Labor Relations Board eine Gewerkschaftswahl und waren erfolgreich. Anschließend wurden wir nur vier Tage nach der Bestätigung unseres Wahlergebnisses darüber informiert, dass wir durch einen Chatbot ersetzt werden würden.“

Nach Angaben von Harper wurden die Mitarbeiter der Beratungsstelle darüber informiert, dass sie ab dem 1. Juni arbeitslos sein würden. Da die Organisation mehr Mitarbeiter für die Beratungsstelle und einen Chatbot benötigt, gibt es derzeit niemanden, der denjenigen, die Hilfe benötigen, bei der Kontaktaufnahme mit der Organisation hilft.

Harper schloss: „Wir werden unseren Kampf fortsetzen. Obwohl wir zahlreiche Fälle vorhersehen, in denen Technologie uns bei unserer Arbeit in der Helpline unterstützen könnte, werden wir nicht zulassen, dass unsere Vorgesetzten einen Chatbot einsetzen, um unsere Gewerkschaft und unsere Arbeitsplätze zu beseitigen.“

Thompson erklärte gegenüber The Guardian, dass der Chatbot nicht als Ersatz für die Helpline gedacht war, sondern als unabhängiges Programm konzipiert wurde. „Unsere Entscheidung, die Helpline zu schließen, beruhte auf geschäftlichen Gründen, eine Entscheidung, die wir seit drei Jahren in Erwägung gezogen hatten“, sagte Thompson. „Selbst ein fortschrittliches Programm wie ein Chatbot kann die menschliche Interaktion nicht ersetzen.“

Die zunehmende Verbreitung von KI und Chatbots hat zahlreiche Unternehmen und Technikexperten vor Herausforderungen gestellt und ihnen Sorgen bereitet, da sich herausgestellt hat, dass einige Bots Voreingenommenheit fördern und Fehlinformationen verbreiten. So veröffentlichte Meta im Jahr 2022 einen Chatbot, der antisemitische Kommentare abgab und Facebook verunglimpfte.

Während sich die Technologie weiterentwickelt, bemühen sich Länder auf der ganzen Welt um die Einführung von Vorschriften. Die Europäische Union ist mit ihrem KI-Gesetz, das voraussichtlich noch in diesem Jahr ratifiziert werden wird, führend.

Dieser Vorfall unterstreicht die Notwendigkeit einer genauen Prüfung und umfassender Tests von KI-Anwendungen vor deren Einsatz, insbesondere in sensiblen Bereichen wie der psychischen Gesundheit. Die missbräuchliche Verwendung oder Fehlfunktion solcher Geräte kann potenziell schädliche Folgen haben. Da die Tech-Industrie weiterhin mit künstlicher Intelligenz experimentiert, müssen Entwickler, Organisationen und Regierungen zusammenarbeiten, um strenge Richtlinien und Vorschriften festzulegen, die die Sicherheit und das Wohlbefinden der Nutzer in den Vordergrund stellen.