Der Aufstieg der künstlichen Intelligenz (KI) bei der Bilderzeugung hat sowohl bei Suchmaschinen als auch bei Nutzern zu erheblichen Bedenken geführt. Von ethischen Fragen wie gestohlenen Kunstwerken bis hin zu den Auswirkungen auf die Umwelt und der Verbreitung von Fehlinformationen – KI-generierte Bilder verändern die digitale Landschaft sowohl auf subtile als auch auf alarmierende Weise. Diese Bilder, die früher auf spezielle Kunstprojekte oder Neuheiten beschränkt waren, tauchen jetzt häufig in den Ergebnissen von Mainstream-Suchmaschinen auf und werfen Fragen zur Authentizität und Genauigkeit auf.

Die wachsende Präsenz von KI-generierten Bildern

In den letzten Monaten haben KI-generierte Bilder begonnen, ganz oben in den Ergebnissen der Bildersuche auf großen Plattformen wie Google und Bing zu erscheinen. Diese Bilder sind oft auf den ersten Blick nicht von echten Fotos zu unterscheiden, so dass Nutzer sie leicht mit echten Bildern verwechseln können. Einige dieser Bilder sind harmlos und wurden für künstlerische oder kommerzielle Zwecke erstellt. Viele andere jedoch verbreiten absichtlich oder unabsichtlich Fehlinformationen, und dieser Trend hat eine neue Ebene der Komplexität im Kampf gegen gefälschte Inhalte im Internet geschaffen.

Ein bemerkenswertes Beispiel sind die irreführenden „Baby-Pfau“-Bilder. Wenn Nutzer auf Plattformen wie Bing und Google nach diesem Begriff suchen, stoßen sie auf KI-generierte Bilder, die den Vogel mit übertriebenen, fast cartoonhaften Merkmalen zeigen – große, Disney-artige Augen und unnatürlich blaue Federn. Diese Darstellungen sind alles andere als akkurat; in Wirklichkeit sind Baby-Pfauen braun und haben normale, unauffällige Augen und Beine. Diese Verbreitung visuell beeindruckender, aber falscher Bilder führt Nutzer in die Irre, die sich möglicherweise nicht bewusst sind, dass sie eine von einer KI generierte Kreation betrachten.

Die Herausforderungen bei der Kennzeichnung von KI-generierten Inhalten

Als Reaktion auf diese Probleme hat Google angekündigt, in den kommenden Monaten KI-generierte Bilder zu kennzeichnen und diese Informationen in die Metadaten des Bildes aufzunehmen. Dies wird mit Hilfe der Content Credentials für Bilder geschehen, die Content Provenance and Authenticity (C2PA) Metadaten enthalten. Diese Lösung hat jedoch eine Einschränkung: Sie gilt nur für Bilder, die nach dem C2PA-Standard erstellt oder geändert wurden. Es gibt derzeit keinen Plan, wie KI-generierte Bilder, die diese Metadaten nicht enthalten, behandelt werden sollen.

Diese Inkonsistenz bei der Kennzeichnung ist besonders besorgniserregend, da KI-generierte Inhalte immer ausgefeilter und schwieriger von echten Bildern zu unterscheiden sind. Während einige Plattformen daran arbeiten, diese Probleme zu lösen, bleibt die Tatsache bestehen, dass KI-generierte Bilder weiterhin neben echten Bildern angezeigt werden, was zu Fehlinformationen in den täglichen Suchergebnissen beiträgt.

Erkennen Sie die Unterschiede: Wie Sie KI-generierte Bilder erkennen können

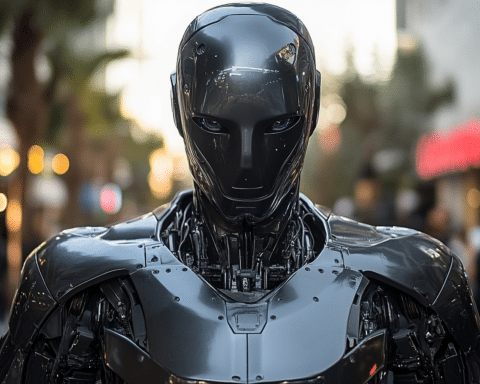

Obwohl KI-generierte Bilder recht realistisch sein können, weisen sie oft verräterische Merkmale auf, mit denen Benutzer sie von echten Fotos unterscheiden können. Die offensichtlichsten Fehler finden sich oft bei den Gesichtszügen und Gliedmaßen. KI-generierte Bilder von Tieren, wie z.B. der „Baby-Pfau“, können unnatürlich große Augen oder andere anatomisch falsche Elemente aufweisen. Gliedmaßen, Finger und Beine in von Menschen generierten Bildern erscheinen oft verzerrt oder falsch platziert, da die KI Schwierigkeiten hat, diese Teile genau zu replizieren.

Neben den körperlichen Merkmalen gibt es auch subtile Unstimmigkeiten bei Beleuchtung, Textur und Schattenwurf, die der KI häufig unterlaufen. Diese Fehler sind vielleicht nicht auf den ersten Blick ersichtlich, aber bei genauerer Betrachtung erkennt man oft Farben, die nicht übereinstimmen, Texturen, die unnatürlich glatt sind, oder Lichtquellen, die sich nicht so verhalten, wie sie es in einer realen Umgebung tun würden. Auch Hintergrunddetails, wie Objekte oder Text, können den künstlichen Ursprung eines Bildes verraten. In einem berüchtigten Fall lud ein KI-generiertes Plakat für eine Schokoladenmarke die Betrachter zu einem „Paradies der süßen Zitzen“ ein – ein humorvolles, aber eindeutiges Beispiel für KI-generierte Textfehler.

Die umfassenderen Auswirkungen von KI in Suchmaschinen

Die zunehmende Verbreitung von KI-generierten Bildern in Suchmaschinen hat schwerwiegende Folgen, insbesondere wenn es um Fehlinformationen geht. Selbst wenn die Bilder selbst nicht absichtlich irreführend sind, kann ihre Präsenz in den Suchergebnissen Verwirrung stiften, insbesondere bei Nutzern, die nicht erkennen, dass sie eine KI-Kreation sehen. Erschwerend kommt hinzu, dass viele dieser Bilder nicht ordnungsgemäß beschriftet oder mit einem Haftungsausschluss versehen sind.

Da sich die KI-Technologie weiter entwickelt, müssen Suchmaschinen robustere Lösungen zur Identifizierung und Kennzeichnung von KI-generierten Inhalten implementieren. Während die von Google angekündigten Schritte ein positiver Anfang sind, bleibt das größere Problem der Regulierung und Überwachung von KI-generierten Inhalten ungelöst.

In der Zwischenzeit müssen die Nutzer wachsam bleiben und lernen, die subtilen Anzeichen von KI-generierten Bildern zu erkennen. Indem sie visuelle Ungereimtheiten erkennen und genau auf Hintergrunddetails achten, können die Nutzer dazu beitragen, die Verbreitung von Fehlinformationen zu verhindern und eine genauere digitale Landschaft zu erhalten.