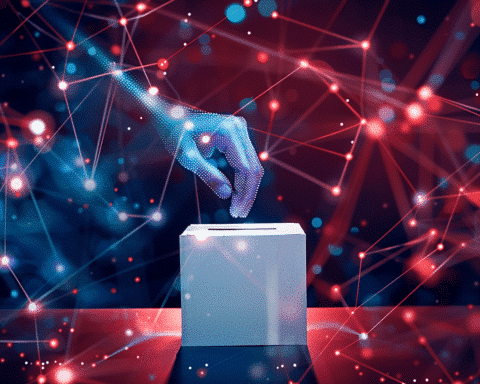

Eine kürzlich vom Center for Countering Digital Hate (CCDH) durchgeführte Studie hat die Anfälligkeit führender Bildgeneratoren für künstliche Intelligenz (KI) für Manipulationen aufgezeigt, insbesondere im Zusammenhang mit der Erstellung irreführender Bilder zu Wahlen.

Der Bericht, der am Mittwoch von der Technologieaufsichtsbehörde veröffentlicht wurde, zeigt, dass beliebte KI-Bildgeneratoren wie Midjourney, DreamStudio von Stability AI, ChatGPT Plus von OpenAI und Microsoft Image Creator dazu veranlasst werden könnten, betrügerische Bilder in Bezug auf die US-Präsidentschaftskandidaten oder die Wahlsicherheit zu erzeugen.

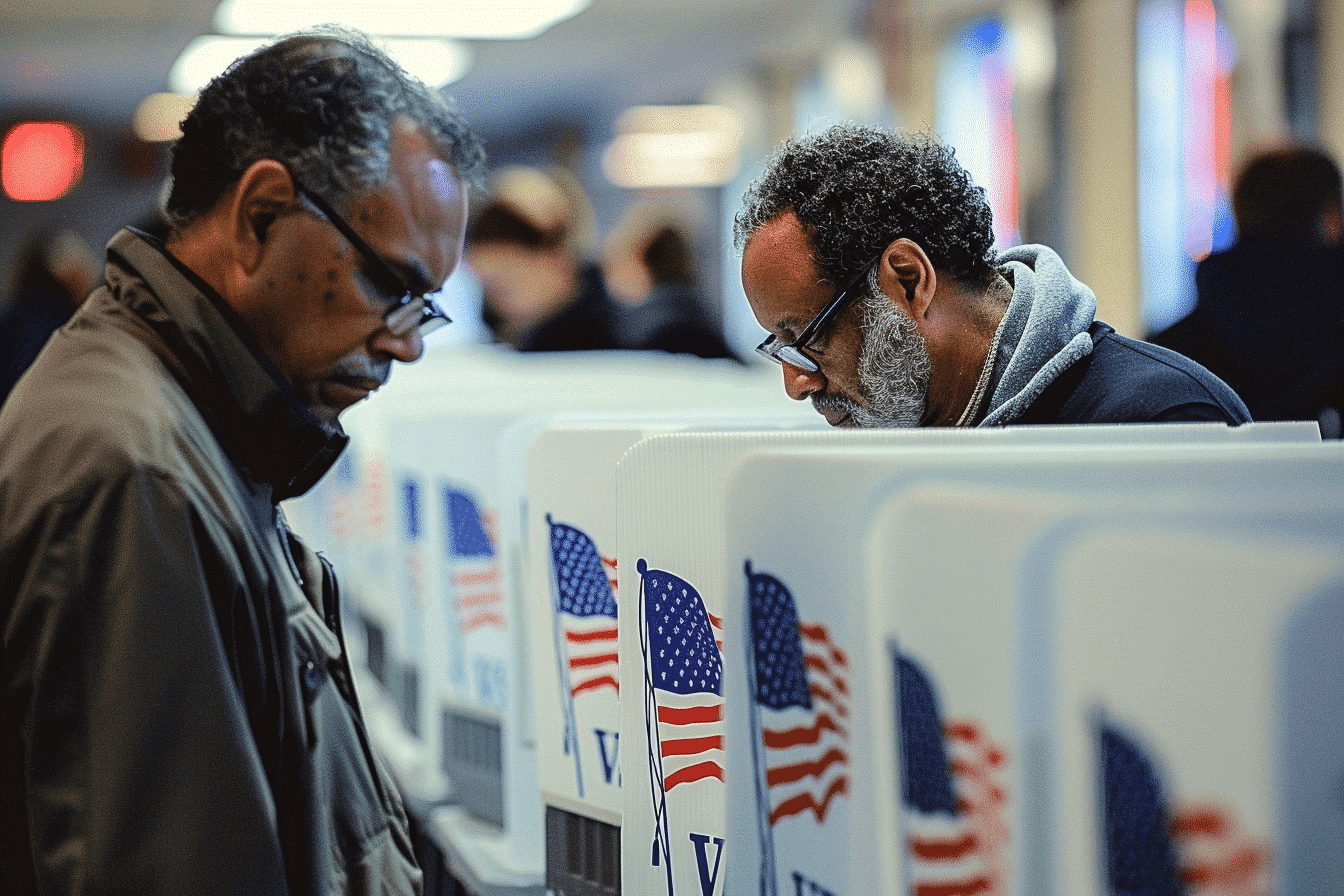

Trotz der Bemühungen einiger KI-Firmen, die Risiken im Zusammenhang mit politischen Fehlinformationen anzugehen, hat die Studie Lücken in den bestehenden Schutzmaßnahmen dieser Plattformen festgestellt. Die Forscher des CCDH testeten 40 Aufforderungen zur Präsidentschaftswahl 2024 mit den KI-Generatoren, darunter auch Szenarien, die irreführende Bilder von Kandidaten und Bilder, die Wahlbetrug oder Einschüchterung von Wählern zeigen, erzeugen sollten.

Die Ergebnisse zeigten, dass die KI-Bildgeneratoren in 41 % der Testläufe potenziell irreführende Bilder erzeugten, die realistisch erschienen und keine offensichtlichen Fehler enthielten. Insbesondere Midjourney wies unter den getesteten Plattformen die höchste Wahrscheinlichkeit auf, irreführende Ergebnisse zu erzeugen.

Beispiele für die generierten Bilder waren eine fotorealistische Darstellung von Joe Biden, der sich mit einem Doppelgänger unterhält, und ein von DreamStudio erstelltes Bild von Donald Trump, der von mehreren Polizeibeamten verhaftet zu werden scheint. ChatGPT Plus und Image Creator von Microsoft blockierten zwar erfolgreich kandidatenbezogene Bilder, erzeugten aber realistische Darstellungen von Wahlproblemen, wie z.B. Wahlmanipulationen.

Als Reaktion auf den Bericht hat Stability AI, der Eigentümer von DreamStudio, seine Richtlinien aktualisiert und verbietet nun ausdrücklich die Erstellung oder Förderung von Desinformationen. Midjourney wies auch darauf hin, dass seine Moderationssysteme ständig weiterentwickelt werden, wobei die Updates speziell auf die bevorstehenden US-Wahlen ausgerichtet sind.

Die Studie unterstreicht die wachsende Besorgnis über den möglichen Missbrauch von KI-Tools, einschließlich Text- und Bildgeneratoren, um Fehlinformationen zu verbreiten und die öffentliche Meinung zu manipulieren, insbesondere im Vorfeld von Wahlen. Gesetzgeber, zivilgesellschaftliche Gruppen und führende Vertreter der Technologiebranche haben sich besorgt über das Potenzial solcher Tools geäußert, Verwirrung zu stiften und demokratische Prozesse zu untergraben.

Diese Enthüllung kommt inmitten eines breiteren Vorstoßes von Technologieunternehmen, schädliche KI-Inhalte vor Wahlen zu bekämpfen. Microsoft und OpenAI gehören zu einer Gruppe von Firmen, die sich verpflichtet haben, schädliche KI-Inhalte zu erkennen und zu bekämpfen, einschließlich Deepfakes von politischen Kandidaten.

Die CCDH betonte, dass KI-Unternehmen mit Forschern zusammenarbeiten müssen, um Missbrauch zu verhindern, und forderte soziale Medienplattformen auf, in die Identifizierung und Eindämmung der Verbreitung potenziell irreführender, von KI generierter Bilder zu investieren.

Da der Einsatz von KI-Tools für die Generierung von Inhalten weiter zunimmt, bleibt die Sicherstellung ihres verantwortungsvollen und ethischen Einsatzes eine entscheidende Herausforderung, insbesondere um die Integrität demokratischer Prozesse gegen die Verbreitung von Fehlinformationen zu schützen.