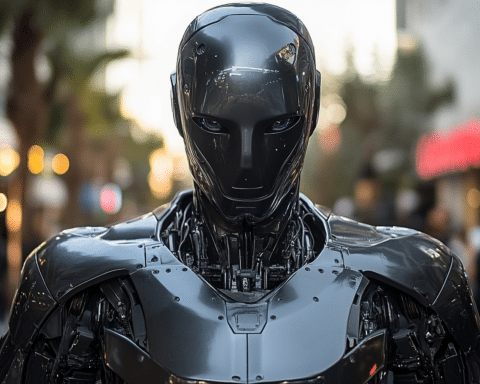

Elon Musks neueste Innovation, der KI-Chatbot Grok, hat seit seiner kürzlichen Einführung auf der Social-Media-Plattform X schnell für Kontroversen gesorgt. Das Tool ermöglicht es Benutzern, KI-generierte Bilder aus Textaufforderungen zu erstellen, und es dauerte nicht lange, bis die Benutzer die Seite mit gefälschten Bildern politischer Persönlichkeiten überfluteten. Die Bilder, von denen einige diese Personen in beunruhigend falschen Szenarien zeigen, haben erhebliche Bedenken hinsichtlich des möglichen Missbrauchs von KI-Technologie aufgeworfen.

Im Gegensatz zu anderen gängigen KI-Foto-Tools scheint Grok, das von Musks Startup xAI entwickelt wurde, keine strengen Leitplanken zu haben. CNN hat Grok getestet und dabei festgestellt, dass es irreführende, fotorealistische Bilder von Politikern und politischen Kandidaten erzeugen kann, die leicht aus dem Zusammenhang gerissen werden und die Wähler in die Irre führen können. Das Tool erzeugte auch harmlose und dennoch überzeugende Bilder von Persönlichkeiten des öffentlichen Lebens, wie z.B. Musk selbst beim Steakessen in einem Park, was seine Vielseitigkeit und sein Missbrauchspotenzial unterstreicht.

Die Leichtigkeit, mit der Nutzer diese Bilder auf X erstellt und gepostet haben, unterstreicht die wachsende Sorge, dass KI zu einer Explosion falscher oder irreführender Informationen im Internet beitragen könnte, insbesondere im Vorfeld der US-Präsidentschaftswahlen. Gesetzgeber, zivilgesellschaftliche Gruppen und sogar führende Techniker haben ihre Besorgnis über die chaotischen Auswirkungen solcher Tools auf die öffentliche Meinung und das Wählerverhalten zum Ausdruck gebracht.

Führende KI-Unternehmen haben Maßnahmen ergriffen, um zu verhindern, dass ihre Tools zur Erstellung politischer Fehlinformationen verwendet werden. Trotz dieser Bemühungen haben Forscher herausgefunden, dass Benutzer manchmal die Durchsetzungsmaßnahmen umgehen können. Unternehmen wie OpenAI, Meta und Microsoft setzen Technologien oder Kennzeichnungen ein, die dem Betrachter helfen, KI-generierte Bilder zu identifizieren. Soziale Medienplattformen wie YouTube, TikTok, Instagram und Facebook haben ebenfalls Strategien zur Kennzeichnung von KI-generierten Inhalten eingeführt, entweder durch Erkennungstechnologien oder indem sie die Nutzer auffordern, solche Inhalte selbst zu identifizieren.

Die Reaktion von X auf den möglichen Missbrauch von Grok bleibt jedoch unklar. Die Plattform hat eine Richtlinie gegen das Teilen von synthetischen, manipulierten oder aus dem Zusammenhang gerissenen Medien, die Menschen täuschen oder verwirren könnten, aber die Durchsetzung dieser Richtlinie ist fraglich. Musk selbst hat bereits KI-generierte Inhalte auf X geteilt, die Aussagen von Harris falsch wiedergegeben haben und nur von einem Emoji mit lachendem Gesicht begleitet wurden, um auf die Unwahrheit hinzuweisen.

Der Start von Grok erfolgt inmitten der wiederholten Verbreitung falscher und irreführender Behauptungen von Musk auf X, insbesondere im Zusammenhang mit den Präsidentschaftswahlen. Dazu gehört auch ein kürzlich veröffentlichter Beitrag, in dem die Sicherheit von Wahlmaschinen in Frage gestellt wird. Musks Aktionen haben Kritik auf sich gezogen, insbesondere nach einem langen, per Livestream übertragenen Gespräch mit Trump, in dem der ehemalige Präsident zahlreiche falsche Behauptungen aufstellte, ohne dass Musk dagegen vorging.

Andere KI-Tools zur Bilderzeugung haben wegen verschiedener Probleme ähnliche Rückschläge hinnehmen müssen. Google musste die Bilderzeugungsfunktionen seines Gemini KI-Chatbots pausieren, nachdem kritisiert wurde, dass er historisch ungenaue Darstellungen der Ethnien von Menschen erzeugt. Der KI-Bildgenerator von Meta hatte Probleme mit der Erstellung von Bildern mit unterschiedlichen rassischen Hintergründen und TikTok musste ein KI-Videotool entfernen, nachdem festgestellt wurde, dass es realistische Videos ohne korrekte Kennzeichnung erstellt, darunter auch solche, die falsche Informationen über Impfstoffe verbreiten.

Grok hat einige Einschränkungen. Es weigert sich, Nacktbilder zu erstellen und behauptet, keine Inhalte zu erstellen, die schädliche Stereotypen, Hassreden oder Fehlinformationen fördern. Trotz dieser erklärten Einschränkungen scheint die Durchsetzung von Grok inkonsequent zu sein. In einem Fall erzeugte das Tool ein Bild einer politischen Figur neben einem Symbol für Hassrede, was darauf hindeutet, dass die Beschränkungen möglicherweise nicht immer effektiv angewendet werden.

Die Einführung von Grok hat eine wichtige Diskussion über die Verantwortung von KI-Entwicklern und Social Media-Plattformen bei der Verhinderung der Verbreitung von Fehlinformationen ausgelöst. Mit der Weiterentwicklung der KI-Technologie wird der Bedarf an robusten Schutzmaßnahmen und konsequenten Durchsetzungsmechanismen immer wichtiger, um die Integrität von Informationen im digitalen Zeitalter zu wahren. Die Kontroverse um Grok verdeutlicht das empfindliche Gleichgewicht zwischen Innovation und ethischer Verantwortung im Bereich der künstlichen Intelligenz.